Você já imaginou uma memória tão rápida que poderia revolucionar o desempenho de jogos e aplicações pesadas? Bem, ela já existe há alguns anos e se chama HBM, sigla para High Bandwidth Memory, capaz de oferecer grande largura de banda para transferência de dados, consideravelmente mais do que a tecnologia GDDR6, além da alta capacidade de armazenamento.

Em se tratando de memórias, quanto mais dados trafegam, maior é o desempenho, seja para RAM ou VRAM. É simples assim. No caso da HBM, seu uso é focado em placas de vídeo e aceleradoras de IA para servidores e atualmente está em sua terceira geração, oferecendo 1,2 TB/s e capacidade máxima de 32 GB por stack, sendo bem mais considerando toda a construção da placa.

Como funcionam as memórias HBM?

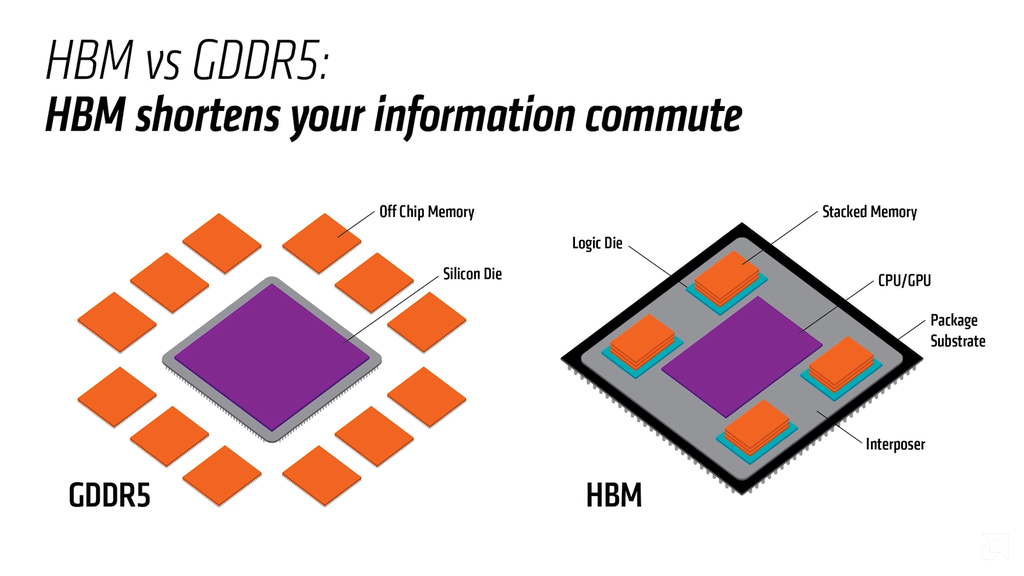

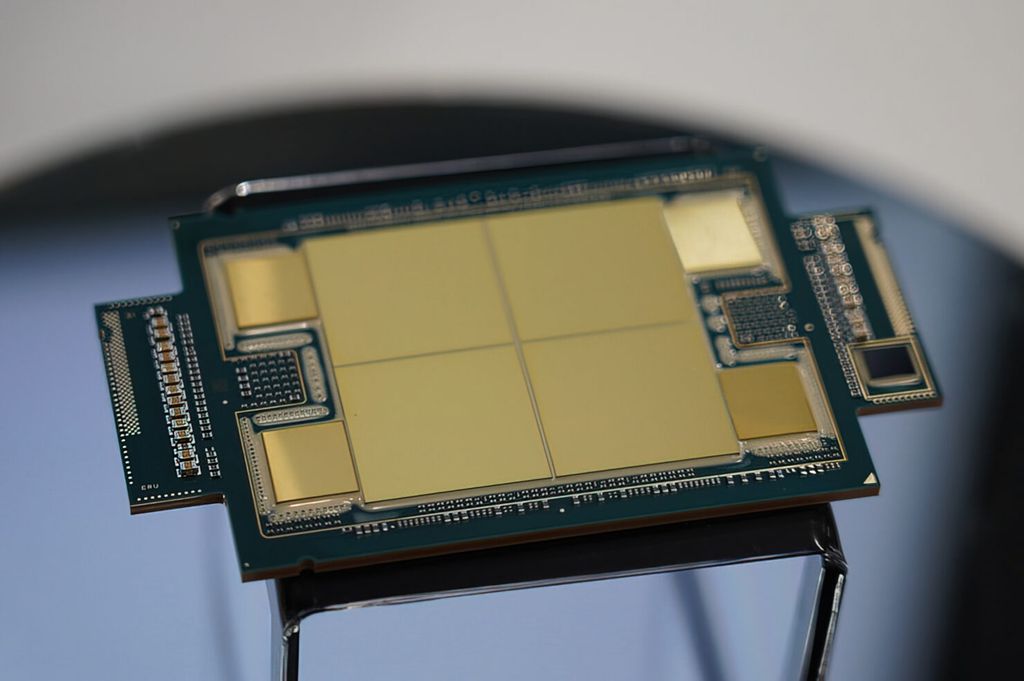

A tecnologia de memória HBM é diferente do que vemos com o tradicional GDDR. Como estamos falando de um tipo de memória de vídeo, a relacionaremos com a GPU, embora a Intel também faça uso na linha Xeon. No formato padrão usado amplamente, os módulos de memória ficam ao redor da GPU, no PCB da placa principal.

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

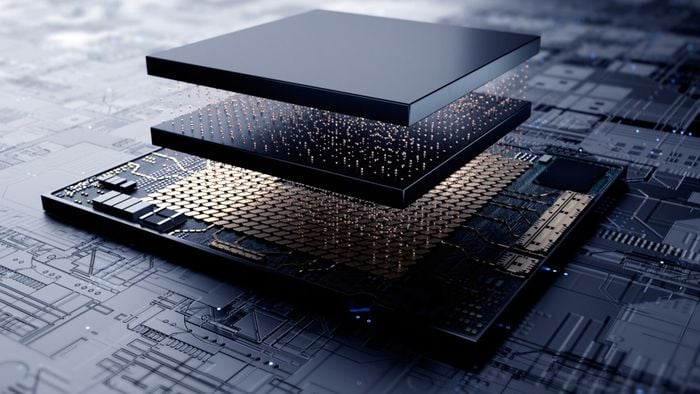

Com HBM, esses módulos são empilhados um em cima um do outro, em diferentes fileiras, que por sua vez ficam em uma base (interposer), onde também está a GPU. Ou seja, o chip principal e as memórias estão mais próximos, agilizando a comunicação entre esses componentes e a redução na latência do tráfego de dados.

A grande largura de banda acontece por conta do empilhamento dos módulos, encurtando o caminho da comunicação. É como se HBM fosse uma estrada com muitas faixas, como aquelas que vemos nos EUA, e a memória GDDR fosse uma estrada, no máximo, duplicada que temos comumente no Brasil. Por isso, o fluxo de dados é maior.

Vantagens e desvantagens das memórias HBM

Como tudo na vida, existem vantagens e desvantagens com as memórias HBM. Como já mencionado, a maior vantagem é sua largura de banda, algo que aumenta consideravelmente o desempenho em aplicações sensíveis a isso, como inferência de IA.

Outro aspecto positivo é a maior capacidade de armazenamento por stack, chegando a 288 GB na GPU Blackwell GB300 da NVIDIA, por exemplo. Por conta de sua construção, existe uma diminuição na latência, gerando uma comunicação e transferência de dados mais rápida. Isso também implica na eficiência da tecnologia, que gera menos calor e consome menos energia.

Por outro lado, o processo de produção das memórias HBM em relação a GDDR6, por exemplo, é mais delicado e, por isso, mais caro. Isso também reflete na complexidade da implementação na prática. A situação foi ainda pior no início, quando existia uma limitação considerável dessa tecnologia, justamente por ser algo novo.

Aplicações práticas das memórias HBM

Apesar de ter feito sua estreia em jogos com a placa de vídeo Radeon R9 Fury X da AMD em 2015, o foco das memórias HBM está em aplicações profissionais hoje em dia. Nesse segmento de games, a entrega ficou aquém do entusiasmo com a nova tecnologia. Apesar dos 4096-bit (por causa dos stacks de memória) ter chamado muito a atenção, a GPU era limitada a 4 GB, diferente dos 6 GB GDDR5 da rival GeForce GTX 980 Ti, que era levemente mais forte.

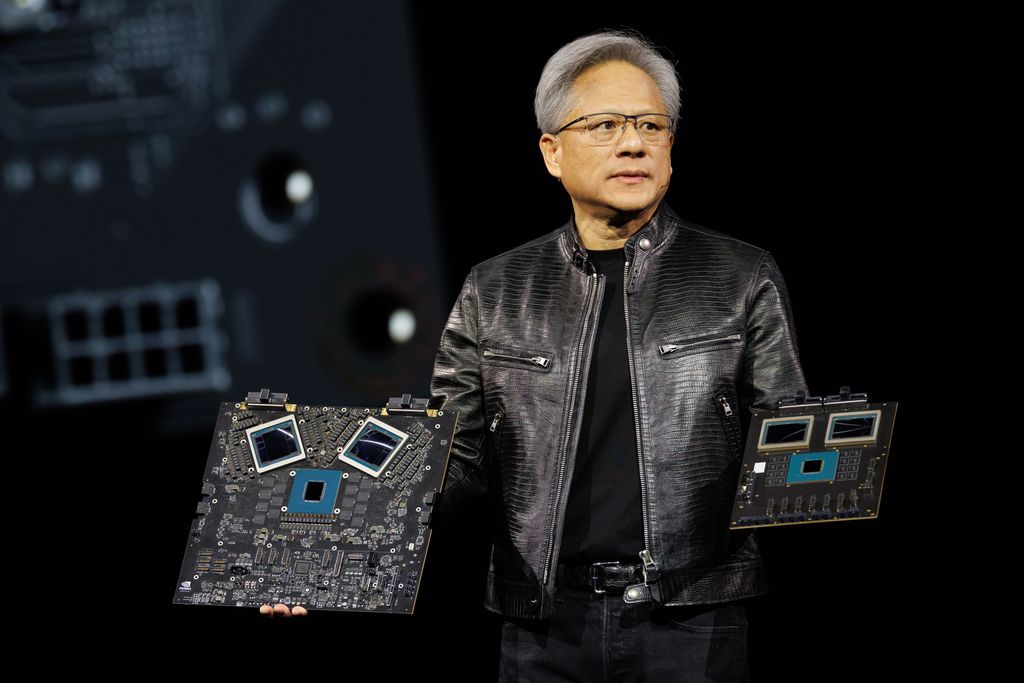

Hoje, com a evolução da tecnologia, aumentando a capacidade de armazenamento, largura de banda e eficiência, existe um apelo maior em placas profissionais e aceleradoras de IA, como os da NVIDIA, que rodam aplicações que se beneficiam muito das memórias HBM.

Data centers equipados com placas com essa tecnologia fazem inferência de LLMs com grande desempenho. Uma NVIDIA H100 com HBM3, por exemplo, oferece 80 GB com barramento de 5120-bit, entregando 3,35 TB/s. Ou seja, enquanto em jogos não deu certo por diferentes motivos, HBM é o futuro para aplicações profissionais e, principalmente, IA.

Futuro das memórias HBM

As principais fabricantes de memórias HBM do mundo, SK Hynix, Samsung e Micron, trabalham na melhoria da tecnologia, que atualmente está na terceira geração. Elas já trabalham no HBM4, principalmente para atender à crescente demanda por hardware para IA impulsionada pela NVIDIA, que já pretende lançar placas com essa nova geração em 2025.

Para inteligência artificial, o futuro da tecnologia HBM é promissor, já que as otimizações que estão sendo feitas garantirão largura de banda e velocidade ainda maiores, consumo menor, o dobro da capacidade de armazenamento em relação ao HBM3e e mais inovações.

Existe potencial para placas de vídeo focadas em jogos com HBM, mas será preciso passar por uma barreira importante: o custo da implementação. Existem rumores de que as placas de vídeo GeForce RTX 50 são mais caras do que o normal por conta dos custos da implementação das memórias GDDR7 recém-lançadas, o que dizer, então, da HBM que é mais complexa? Só o tempo mostrará.

Conclusão

Apesar de ter tido um início tímido e turbulento em placas de vídeo para jogos, a tecnologia de memórias HBM encontrou seu lugar em aplicações profissionais e inferência de IA. A tendência é que exista um utilidade ainda mais ampla em aceleradoras de inteligência artificial, principalmente com a NVIDIA suprindo quase o mundo inteiro sozinha e demandando esse tipo de tecnologia.

Não resta dúvida de que as memórias HBM trouxeram inovações sobre o tradicional GDDR, se tornando uma outra opção em relação ao monopólio dessa tecnologia, que existe há muitos anos. Mas, por enquanto, os altíssimos custos de produção e de implementação ainda impedem a acessibilidade a essa inovação.

Veja mais do CTUP:

- Conheça os 6 principais problemas das GeForce RTX 50

- Características mais importantes nos processadores Intel

- Radeon RX 9070: 4 novidades incríveis das novas GPUs da AMD

Leia a matéria no Canaltech.

Fonte: Canaltech - Leia mais